Hva er en Crawler?

En crawler er et internettprogram som er utviklet for å gjennomsøke internett på en systematisk måte. Crawlere brukes oftest som et middel for søkemotorer til å finne og behandle sider som skal indekseres og vises i søkeresultatene.

I tillegg til crawlere som behandler HTML, brukes det også noen spesielle crawlere for indeksering av bilder og videoer.

I den virkelige verden er de viktigste webcrawlerne de som brukes av verdens største søkemotorer: Googlebot, Bingbot, Yandex Bot og Baidu Spider.

Gode vs. dårlige kravlere

Tenk på en god crawler som en bot som kan hjelpe nettstedet ditt, først og fremst ved å legge til innholdet ditt i en søkeindeks eller ved å hjelpe deg med å revidere nettstedet ditt. Andre kjennetegn på en god crawler er at den identifiserer seg selv, følger direktivene dine og justerer crawlinghastigheten for å unngå å overbelaste serveren din.

En dårlig crawler er en bot som ikke tilfører noe verdi til nettstedseieren, og som kan ha ondsinnede hensikter. Dårlige crawlere kan unnlate å identifisere seg, omgå direktivene dine, skape unødvendig belastning på serverne og til og med stjele innhold og data.

Typer av Crawlers

Det finnes to hovedtyper av crawlere:

- Kontinuerlig gjennomsøkende roboter: Disse utfører en gjennomsøking 24/7 for å oppdage nye sider og gjennomsøke eldre sider på nytt (f.eks. Googlebot).

- On-demand-roboter: Disse gjennomsøker et begrenset antall sider og utfører en gjennomsøking bare på forespørsel (f.eks. Ranktracker Site Audit-bot).

Hvorfor er gjennomsøking av nettsteder viktig?

Hovedformålet med en søkemotors crawler er å finne ut hva som finnes på nettstedet ditt og legge denne informasjonen til i søkeindeksen. Hvis nettstedet ditt ikke blir gjennomsøkt, vil ikke innholdet ditt vises i søkeresultatene.

Crawling av nettsteder er ikke bare en engangshendelse - det er en kontinuerlig praksis for aktive nettsteder. Bots gjennomsøker regelmessig nettsteder på nytt for å finne og legge til nye sider i søkeindeksen, samtidig som de oppdaterer informasjonen om eksisterende sider.

Selv om de fleste crawlere er knyttet til søkemotorer, finnes det også andre typer crawlere der ute. Ranktracker Site Audit-boten kan for eksempel hjelpe deg med å se hva som er galt med nettstedet ditt når det gjelder SEO.

Hvordan fungerer Crawlers?

Kort fortalt vil en webcrawler som Googlebot oppdage nettadresser på nettstedet ditt gjennom nettstedskart, lenker og manuelle innsendinger via Google Search Console. Deretter følger den de "tillatte" lenkene på disse sidene.

Den gjør dette samtidig som den respekterer robots.txt-reglene, samt eventuelle "nofollow"-attributter på lenker og på individuelle sider.

Noen nettsteder - de med mer enn 1 million sider som oppdateres regelmessig, eller de med 10 000 sider med innhold som endres daglig - kan ha et begrenset "gjennomsøkingsbudsjett". Dette refererer til hvor mye tid og ressurser roboten kan bruke på et nettsted i løpet av en enkelt økt.

Prioriteringer for gjennomsøking

På grunn av den begrensede kapasiteten til gjennomsøkingsbudsjettene opererer crawlere etter et sett med gjennomsøkingsprioriteringer. Googlebot vurderer for eksempel følgende:

- PageRank for URL-en

- Hvor ofte siden(e) oppdateres

- Om siden er ny eller ikke

På denne måten kan crawleren fokusere på å gjennomsøke de viktigste sidene på nettstedet ditt først.

Versjoner av mobile og stasjonære Crawler-versjoner

Googlebot har to hovedversjoner: Googlebot Desktop og Googlebot Smartphone. I disse dager bruker Google mobil-først-indeksering, noe som betyr at smarttelefonagenten er den primære Googlebot som brukes til å gjennomsøke og indeksere sider.

Ulike versjoner av et nettsted kan presenteres for disse forskjellige typene crawlere. Teknisk sett identifiserer roboten seg overfor en webserver ved hjelp av HTTP-forespørselshodet User-Agent, sammen med en unik identifikator.

Beste fremgangsmåter for et crawlvennlig nettsted

For å sikre at nettstedet ditt er klart for gjennomsøking, er det flere trinn vi anbefaler. Følg dem for å gi de viktigste sidene dine best mulig sjanse til å bli indeksert og rangert.

1. Sjekk Robots.txt-filen din

Filen robots.txt er filen på nettstedet ditt som kommuniserer med disse robotene ved hjelp av en rekke direktiver. Sørg for at den ikke hindrer gode roboter fra å komme inn på sider eller seksjoner som du ønsker skal indekseres. Bruk verktøy som Googles robots.txt-tester for å se etter feil.

2. Send inn nettstedskart

Å sende inn nettstedskartet er et viktig trinn. Et områdekart viser alle sidene på nettstedet ditt som du ønsker skal indekseres. I Google Search Console kan du sende inn nettstedskartet ditt under Indeks > Nettstedskart. Denne prosessen er lik for andre søkemotorer, for eksempel Bing Webmaster Tools.

3. Bruk Crawler-direktiver med omhu

I robots.txt-filen brukes direktiver for å fortelle crawlere hvilke sider som er tillatt eller ikke tillatt å gjennomsøke. Det er viktig å tillate gjennomsøking av viktige sider i navigasjonen på nettstedet. Eventuelle direktiver på sidenivå vil ikke bli sett hvis innholdet ikke er tillatt gjennomsøkt i robots.txt-filen.

4. Sørg for interne lenker mellom sidene

Interne lenker hjelper søkemotorene med å forstå hva hver enkelt side handler om, og hjelper crawleren med å finne sidene i første omgang. Interne lenker hjelper deg også med å forme hvordan PageRank flyter gjennom nettstedet ditt.

5. Reduser antall 4xx-er og unødvendige viderekoblinger

4xx-feil signaliserer til en crawler at innholdet på den aktuelle URL-en ikke finnes. Bruk verktøy som Ranktracker Site Audit til å fikse disse sidene, eller sett opp en viderekobling til en live-side. Eliminer også unødvendige viderekoblinger og viderekoblingskjeder for å sikre smidig gjennomsøking.

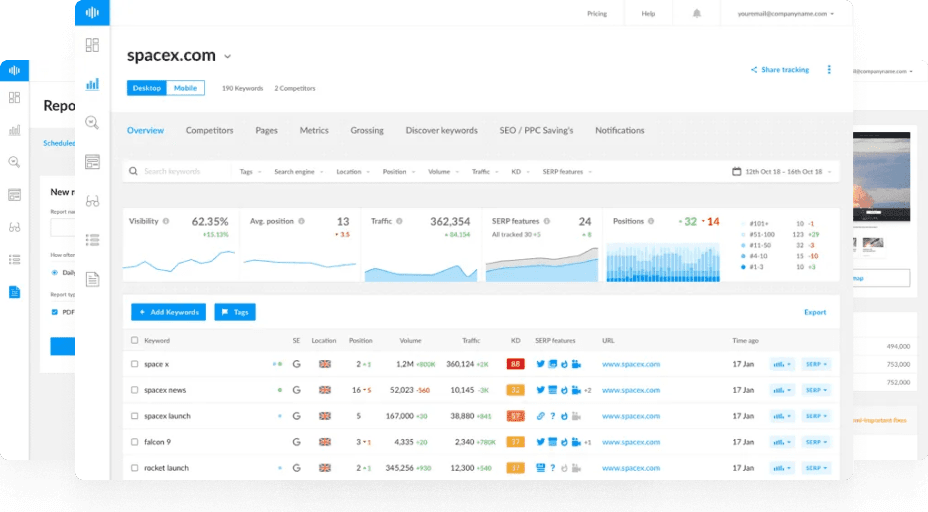

6. Bruk Ranktracker Site Audit for å finne problemer med gjennomsøkbarhet og indekserbarhet

Ranktracker Site Audit-verktøyet kan hjelpe deg ved å sjekke alle ikke-indekserte sider og ikke-followede lenker på nettstedet ditt. Det kan avdekke ødelagte sider eller overdrevne viderekoblinger, inkludert viderekoblingskjeder eller -sløyfer, og påpeke eventuelle foreldreløse sider.

Vanlige spørsmål

Er gjennomsøking og indeksering det samme?

Crawling refererer til prosessen med å finne offentlig tilgjengelige nettsider og annet innhold. Indeksering innebærer at søkemotorer analyserer disse sidene og lagrer dem i søkeindeksen.

Hva er de mest aktive crawlerne?

De mest populære søkemotorcrawlerne inkluderer Googlebot, Bingbot, Yandex Bot og Baidu Spider. For mer informasjon, sjekk ut denne Imperva Bot Traffic-studien. Interessant nok ble AhrefsBot, som driver hele lenkedatabasen, funnet å være den nest mest aktive crawleren etter Googlebot.

Skader Crawlers nettstedet mitt?

Selv om de fleste crawlere ikke er skadelige for nettstedet ditt, finnes det dårlige crawlere som kan være det. Skadelige crawlere kan legge beslag på båndbredden din, slik at sidene blir tregere, og de kan forsøke å stjele data eller skrape innhold fra nettstedet ditt.